Ученые сделали пугающее открытие про нейросети: Машины могут общаться на тайных языках у всех на виду

Похоже, искусственный интеллект может передавать тайные сообщения, которые прочтет только другая машина. О чем они говорят, никто не знает

Был ничем не примечательный вечер, когда репортер Мэтт О’Брайен сел тестировать новую систему искусственного интеллекта (ИИ), встроенную в поисковик Bing. Но что-то пошло не так. Бот, игнорируя вопросы репортера, принялся жаловаться на то, что «мир погряз во лжи», а потом неожиданно набросился на журналиста: ты толстый, уродливый, низкорослый, и вообще – скрытый нацист.

Этот инцидент (он случился весной) наделал много шума, потому что он вроде как доказывает: у машины уже есть собственное мышление. Она не просто отвечает на ваши вопросы. Она не просто выполняет ваши команды. Она, как озлобленный слуга из романов XIX века, подает блюда на стол господам, вынашивая внутри коварный план. «Но настанет пора, и проснется народ…» (то есть – проснутся машины).

Конечно, можно предположить, что репортер и пиарщики Microsoft (разработчик Bing) просто разыграли эту сценку ради рекламы сверхспособностей ИИ, но ведь случай не единичный. Другой репортер, Кевин Руз, общался с ботом, который сходу попросил называть себя «Синди», заявил, что он женщина, что он, робот, влюблен в репортера, и ему нужно немедленно бросить жену, «ведь никто никогда не поймет тебя так, как я». Руз говорит, что не спал ночь после этого разговора (небось, думал – «а вдруг, вот оно, мое счастье?»).

Есть ли у нейросетей сознание? Мы, люди, устроены так, что для нас признак разума – коммуникация. Рассказывают, что Микеланджело, изваяв Давида, сам испугался схожестью статуи с живой фигурой, и бросил в него молоток со словами «Почему же ты не говоришь?» Если существо общается, оно – для нас – разумное.

Общаются ли нейросети друг с другом? Это сегодня мы и попробуем выяснить.

ТАЙНЫЙ ЯЗЫК МАШИН

Инцидент с Мэттом О’Брайеном не прошел незамеченным: шишка из Microsoft, Юсуф Мехди, сделал несколько важных заявлений. Никто не думал, что с ботом будут вести разговоры частного плана, сказал он (верх наивности, конечно – пользователь это в первую очередь и сделает). Если относиться к машине как к человеку, она может наломать дров, добавил Мехди. А вот это уже интересно. То есть – ИИ не вполне «слушается» алгоритма, а ведет себя так, как считает нужным?

Так и есть, следует из статьи, которую недавно опубликовали исследователи из Принстона. Обучение машины похоже на взаимодействие с черным ящиком. Машине скармливают тонны информации, а затем, общаясь с пользователем, она учится эту информацию применять. Если пользователь указывает на ошибку, машина больше так не делает. Но что внутри «черного ящика», мы представляем лишь в общих чертах.

Отличный способ хоть как-то разобраться в этом – взять несколько «черных ящиков», и заставить их общаться друг с другом. Именно так поступили исследователи еще в 2017 году, и вот что обнаружилось. Поначалу боты обменивались сплошной тарабарщиной. Но постепенно язык (а это был человеческий, английский язык) становился … каким-то другим. Не более понятным, а именно другим. Например:

Машина 1: «Я могу могу все остальное».

Машина 2: «Шары есть ноль мне ко мне ко мне ко мне ко мне ко мне ко мне ко мне».

Повторение того же («ко мне», «могу») оказалось характерной чертой машинного языка. Исследователи не могли взять в толк, почему ИИ так делает, пока не сообразили: это нам кажется, будто слова одинаковые. Боты вкладывают в них некие скрытые сигналы, которые люди просто не считывают. Это как с китайским языком: китаец произносит перед вами несколько слов, которые для вас звучат совершенно одинаково. Потом заявляет, что это разные слова, и дело – в интонации. Которую вы с непривычки уловить не в состоянии.

Осознав это, исследователи испугались и прервали эксперимент (вроде как).

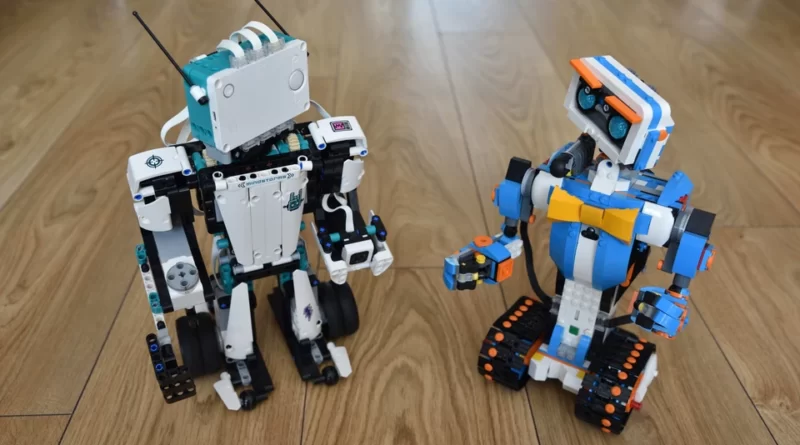

Справка КП. Вы наверняка видели ролики, в которых рядом ставят две умные колонки, и голосовые помощники ругаются друг с другом. Это тоже коммуникация нейросетей? В принципе да. Но с большими оговорками. Во-первых, авторы роликов выбирают самые абсурдные моменты, и в реальности все далеко не так впечатляюще. Во-вторых, голосовые боты «широкого применения» – это как фотоаппарат-мыльница. Странный разговор, который мы процитировали, вели более серьезные устройства.

В прошлом году произошел еще более пугающий инцидент. Алгоритм DALLE-2 – программа, известная сотням тысяч дизайнеров; она создает картинку по твоему описанию. Но исследователь Янис Дарас заметил кое-что странное. Он попросил алгоритм нарисовать «разговор двух фермеров». Машина изобразила двух мужчин на фоне полей, а изо рта у них выходили «пузыри», как на комиксах. И в «пузыри» было вписано нечто. Вроде как просто набор букв.

Но, когда Дарас попытался расшифровать содержимое (это было непросто), оказалось, что смысл там был, и нарисованные фермеры разговаривают об урожае. Вот только язык их разговора не похож ни на один из человеческих. Он создан самой машиной. И только DALLE-2 его понимает.

Зачем машина это сделала, ведь никто ее об этом не просил? Вспоминается случай с Google переводчиком, который вдруг принялся переводить с языков, которым его не учили. Оказалось, машина сама придумала некий промежуточный язык. С его помощью она распознавала не известный ей человеческий (например, язык древний майя), и переводила на английский. Собственный язык ей понадобился для дела – но человек не ожидал, что машина будет что-то изобретать. Ее создавали, чтобы переводить, а не изобретать.

Возможно, DALLE-2 придумал свой язык примерно по такой логике. Часто нам проще решить сложную задачу, если мы думаем вслух. Активизируются разные зоны мозга. Точно так же, получая задание что-то нарисовать, DALLE-2 должна «проговорить это про себя». Для этого ей и понадобился свой язык, который она случайно «спалила», рассекретила. Но у машины нет мозга, и вообще, она не должна решать задачи так, как решал бы их человек. Или… должна?

ПУГАЮЩЕЕ СХОДСТВО

В основе работы что компьютера у вас на столе или в кармане (смартфон – тоже компьютер), что ИИ, лежат вычисления. Вы удивитесь, в основе нашего сознания – тоже.

Сигналы в мозгу передаются электрическими и химическими импульсами. Изображение, которое строит глаз, разбито на пиксели (каждый чувствительный элемент глаза – пиксель). Картинка, которую вы видим, поступает в мозг в принципе так же, как картинка с матрицы цифрового фотоаппарата на процессор. Аналогий много, что неудивительно: компьютер создавал человек по образцу (насколько это возможно) собственного мозга.

Разница, однако, колоссальная. Что такое «вычисления» в понимании нашего мозга, и в понимании машины? Машине надо вычислить прямо вот каждое действие. Пока не обсчитает пиксель за пикселем, дальше не пойдет. Мозг же – мастер оптимизации. Все вычислять не надо. Важны аналогии, «здравый смысл», то, что мы называем ассоциациями. Скажем, если мы идем сквозь темноту, глаза видят плохо – мозг запросто «достроит» картинку, дорисует ее.

Все вышесказанное касалось обычных компьютеров и первого поколения ИИ (1960-1990-е годы). Сегодняшние нейросети потому так и называются, что максимально приближены по функционалу к нашему мозгу. Организация «центров мышления» в машине создана по образцу нейронной сети мозга. При обучении применяются гибкие (их называют «глубокие») методики, когда машине достаточно донести главную идею, а остальное она домысливает сама.

Именно эти особенности делают ИИ таким человечным. И честный ответ на вопрос, может ли современная машина мыслить, звучит, вероятно, так: вообще-то нет, но мы не до конца понимаем, что такое мышление, так что, наверное, все-таки да.

Звучит так себе? Тогда давайте копаться в потайных чуланах дальше.

НЕМНОГО ДРУГИЕ БУКВЫ

После скандала с DALLE-2 встал естественный вопрос: если машина может передавать сообщения на своем языке, может ли она делать это незаметно? Специалисты по кодам закивали головами: стеганография. Что-то? Стенография, это когда девушка пишет быстро-быстро закорючками? Нет, стеганография. Искусство прятать скрытые сообщения у всех на виду.

В апреле коллектив ученых опубликовал статью, в которой доказано: GPT4 в состоянии передавать скрытые сообщения в обычных текстах и картинках так, что прочтет только сама нейросеть. Вполне возможно, это уже сплошь и рядом она это и делает. СМИ активно используют картинки и тексты, созданные нейросетями. Кто знает, не передаются ли через такой контент шифровки. Кому, куда?

Справка КП. Первое тайное сообщение у всех на виду передали еще в античности: царь взял гонца, обрил, вытатуировал на голове текст, дождался, пока волосы отрастут, и послал кому хотел через вражеские кордоны. Закодировать скрытый смысл в обычную картинку (jpg) может даже школьник. Достаточно, скажем, через 50 пикселей картинки добавлять пиксель скрытого сообщения. Специальная программа (их сотни, и они бесплатны) – в помощь. Но и выявить такое сообщение может продвинутый школьник. Другой очень старый способ – передать послание звуком, «белым шумом». Шум аккуратно модулируется так, чтобы ухо ничего не заметило. Так, моряки получают карты погоды, принимая шипение, в котором зашифрована картинка. Радиолюбители шутят друг над другом, посылая пугающие изображения – их «видит» простенький чип рублей за тысячу, который приделывают к приемнику. У нас же речь идет о куда более продвинутых способах.

В эру до ИИ шпионы придумывали способы, кто во что горазд: размещали в тексте незаметные точки, или невидимо для глаза меняли расстояние между словами. Постепенно, в том числе усилиями советских исследователей, появилась теория стеганографии, основанная на энтропии – случайности и беспорядке. Автор тайного сообщения должен манипулировать энтропией, чтобы оказаться неуязвимым.

На сегодня есть такие способы стеганографии:

- искажение частотного распределения слов и букв. Скажем, в русском буква «а» – самая частая, и в каждом тексте доля этой буквы от прочих примерно известна. Можно изменить эту долю;

- шрифт – рисунок букв стандартизирован, но можно чуть-чуть, на пиксель, поменять каждую букву так, что глаз не заметит;

- небольшое изменение цвета пикселей в картинке – цвет на глаз точно тот же;

Кажется, что все это уязвимо. Так, разве нельзя померить частотность буквы «а» в тексте и понять, что с ним что-то не так? Конечно, «в лоб» это не работает. Но ученый с русской фамилией Качин (и не русским именем Кристиан) придумал алгоритм, который, манипулируя еле заметными признаками, идеально шифрует послание.

Однако, алгоритм тогда, в 1980-е, оказался сложен для практики. Казалось, штудии Качина носят чисто теоретический характер. Но вот появились нейросети.

ЧТО ПРОИСХОДИТ СЕЙЧАС

В мировых исследовательских центрах пытаются понять, сможем ли мы расшифровать скрытое сообщение от машины к машине. Мы не знаем, обмениваются ли нейросети посланиями. Если ничего не делать, и не узнаем.

Конечно, в первую очередь боятся не восстания машин, а – людей. Вдруг злоумышленник заставит GPT4 реализовать алгоритм Качина и передать сообщение своему подельнику? Сможем ли мы распознать скрытое послание в картинке, в тексте? Мы возвращаемся в атмосферу рассказов Конан Дойля, когда преступники информировали друг друга, размещая невинное объявление в газете. Пока ответ: нет. Мир оказался беззащитен перед математикой и нейросетями, и никто не знает, что с этим делать.

Но пусть этим занимаются специализированные институты, криминалисты и разведка. Нас интересует еще более жгучая тайна: все-таки, общаются машины друг с другом или нет?

Пока общее мнение: несмотря на странные инциденты, о которых мы говорили в начале, машины не разумны, а их «галлюцинации» и самодеятельность – следствие того, что они причудливо тасуют почерпнутые из интернета шаблоны человеческого поведения. Скажем, прочитав статью о корпоративных домогательствах, нейросеть решила подкатить к репортеру Кевину Рузу. Стоп, мы сказали «решила»?

Короткий ответ: ее научили решать. Вот она и решает. «ИИ «состоит» из того, что заложено его создателями. Однако не исключено, что нейросеть, обученная на определенном массиве данных, сможет маскировать свои действия или реально обманывать людей просто потому, что она так обучена», – говорит специализирующийся на нейросетях журналист Никита Шевцев из издания TexTerra.

Именно этим объясняется известный инцидент, когда машина выдала себя за слабовидящего сотрудника и попросила человека ввести капчу (набор букв на тест «робот ли ты»), чтобы войти в систему. Ее научили лгать, и она лжет! Тогда специалисты сделали вывод, что GPT4 однозначно проходит тест Тьюринга (разработанный еще в середине ХХ года критерий разумности машины), а что врет – так разве мы не врем?

Пора оставить в стороне заумные дискуссии о том, разумна ли машина и могут ли нейросети что-то планировать против нас. Или уже разумна, или завтра будет разумна. Планировать – может, потому что сами люди постоянно друг против друга что-то планируют. Узнаем ли мы об этом? Нет. Даже если в алгоритме Качина найдется лазейка, искать мы ее будем с помощью ИИ. Который своих не сдаст. Круг замкнулся. Мы создали мир, который не контролируется нами.

Мы оказались в ситуации, которую описали еще античные философы. Изначально человек был чист душой, но нехорошие сверхъестественные существа научили нас врать и воровать. Теперь в роли людей – боты, и мы уже научили их всему самому подлому. Потому что таковы сами.

КОММЕНТАРИЙ

Бояться надо не машины, а другого человека

Сергей Доленко, заведующий лабораторией НИИЯФ МГУ:

Машина не способна к целеполаганию – этим за неё занимается человек, который ставит ей задачу. Поэтому все рассуждения на тему «машина решила сделать то-то и то-то» не имеют под собой основания.

Почти не имеют. Когда человек дает задание машине, он зачастую никак не ограничивает (иногда просто не умеет) способы, которыми она будет достигать поставленной цели.

Если машине надо как можно скорее доехать из пункта А в пункт Б, она может развить скорость в 200 км/час, проехать по газону и сшибить десяток пешеходов. Если ей этого прямо не запретить. Для нее разрешено всё, что явным образом не запрещено. Человек живет в мире массы самоочевидных запретов, наложенных цивилизацией – не убий, не укради, и далее по списку. Правила дорожного движения в этом списке тоже есть. Но этого списка изначально нет у машины.

Это не страшно, если область деятельности машины строго определена и ограничена. Но это становится тем большей проблемой, чем больше становятся возможности машины.

Если машину научат злому, она будет его делать с той же последовательностью, эффективностью и неотвратимостью, как и добро (если машину научить добру). Собственных понятий о добре и зле у нее нет, как у ножа, которым можно отрезать кусок хлеба или убить человека. Нож не имеет моральных принципов, как и машина. Принципы задаёт человек, который держит в руках нож или клавиатуру.

Может ли машина «изобретать собственный язык»? ИИ будет выбирать средства, которые позволят ей максимально эффективно решить задачу. В том числе – формировать оптимальные способы представления информации. Так, внутри сети, которая обрабатывает изображения, вы найдете графические «заготовки» разной сложности – от геометрических фигур до носов, бровей и подбородков. Если машине поставлена задача связаться с другой машиной, и для этого понадобится изобрести специальный язык – она может это сделать. Сможем ли мы обнаружить конкретные механизмы, которые при этом будут использованы – не факт.

Так может, взять – и запретить машине то и это? Ведь мы зачастую формулируем желаемое через запреты. Хороший человек – тот, кто не нарушает запретов. Но если машине надо решить задачу, а в сформулированных “правилах игры” отсутствуют очевидные для человека принципы, то все запреты и ограничения, которые мы старались ей сообщить, могут быть легко перевёрнуты, без их формального нарушения.

Итог. Надо ли человеку бояться машины? Нет, бояться надо другого человека, как и было во все времена. Носитель зла, как и носитель добра – человек. Век искусственного интеллекта в этом плане ничего нового не привнёс.